Apprendre à résoudre une tâche sur la base de la maximisation de la récompense nécessite de définir des espaces d’états et d’actions. L’espace d’action décrit ce que le robot sera capable de faire. Concevoir automatiquement cet espace simplifie le travail du concepteur de robot et ouvre la possibilité de découvrir des façons d’agir propres à sa morphologie. Cela permet d’élargir les capacités adaptatives de l’apprentissage par renforcement.

La méthode que l’on utilise pour générer des répertoires d’actions s’appuie sur les algorithmes de qualité-diversité et la recherche de nouveauté (voire Exploration et récompenses rares). Le principe consiste à définir un espace comportemental que l’on souhaite couvrir avec le répertoire d’actions. Les algorithmes de recherche de nouveauté ou de qualité-diversité génèrent un ensemble de politiques diverses couvrant cet espace. Ces politiques peuvent ensuite être utilisées comme actions élémentaires d’un processus de décision markovien de plus haut niveau.

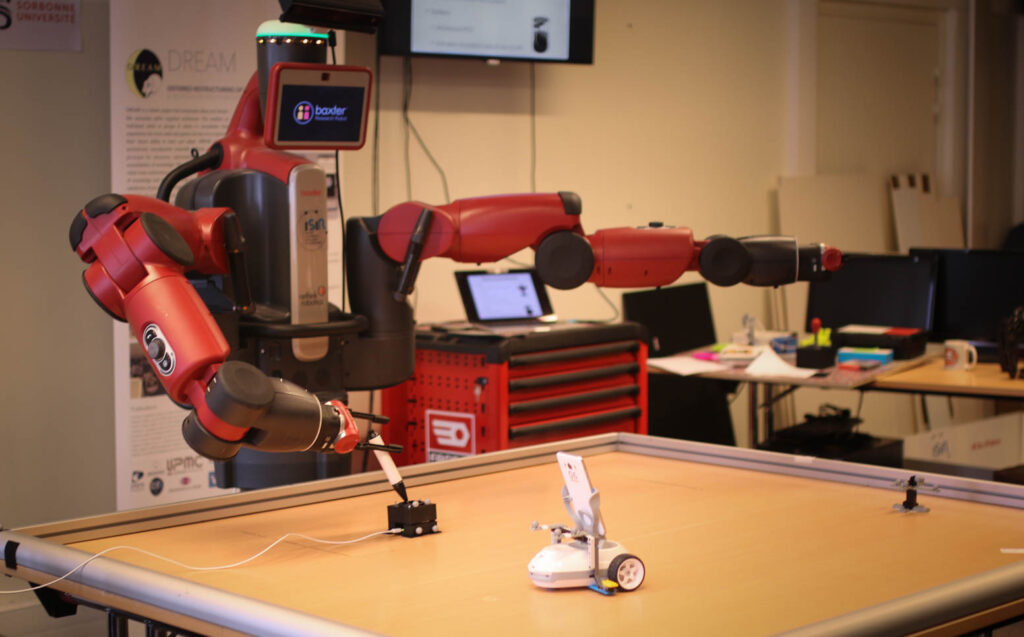

Article sur le sujet: